철학과 학생의 개발자 도전기

패스트캠퍼스 환급챌린지 4일차 : 10개 프로젝트로 한 번에 끝내는 MLOps 파이프라인 구현 초격차 패키지 Online. 강의 후기 본문

패스트캠퍼스 환급챌린지 4일차 : 10개 프로젝트로 한 번에 끝내는 MLOps 파이프라인 구현 초격차 패키지 Online. 강의 후기

Younghun 2025. 3. 8. 14:37본 포스팅은 패스트캠퍼스 환급 챌린지 참여를 위해 작성하였습니다.

봄맞이 특급 혜택 '하나 더 봄'🌸 1+1 이벤트 (3/4~3/9) | 패스트캠퍼스

당신의 성장도 피어날 거예요. 1+1 쿠폰으로 강의 보고 또 보고!

fastcampus.co.kr

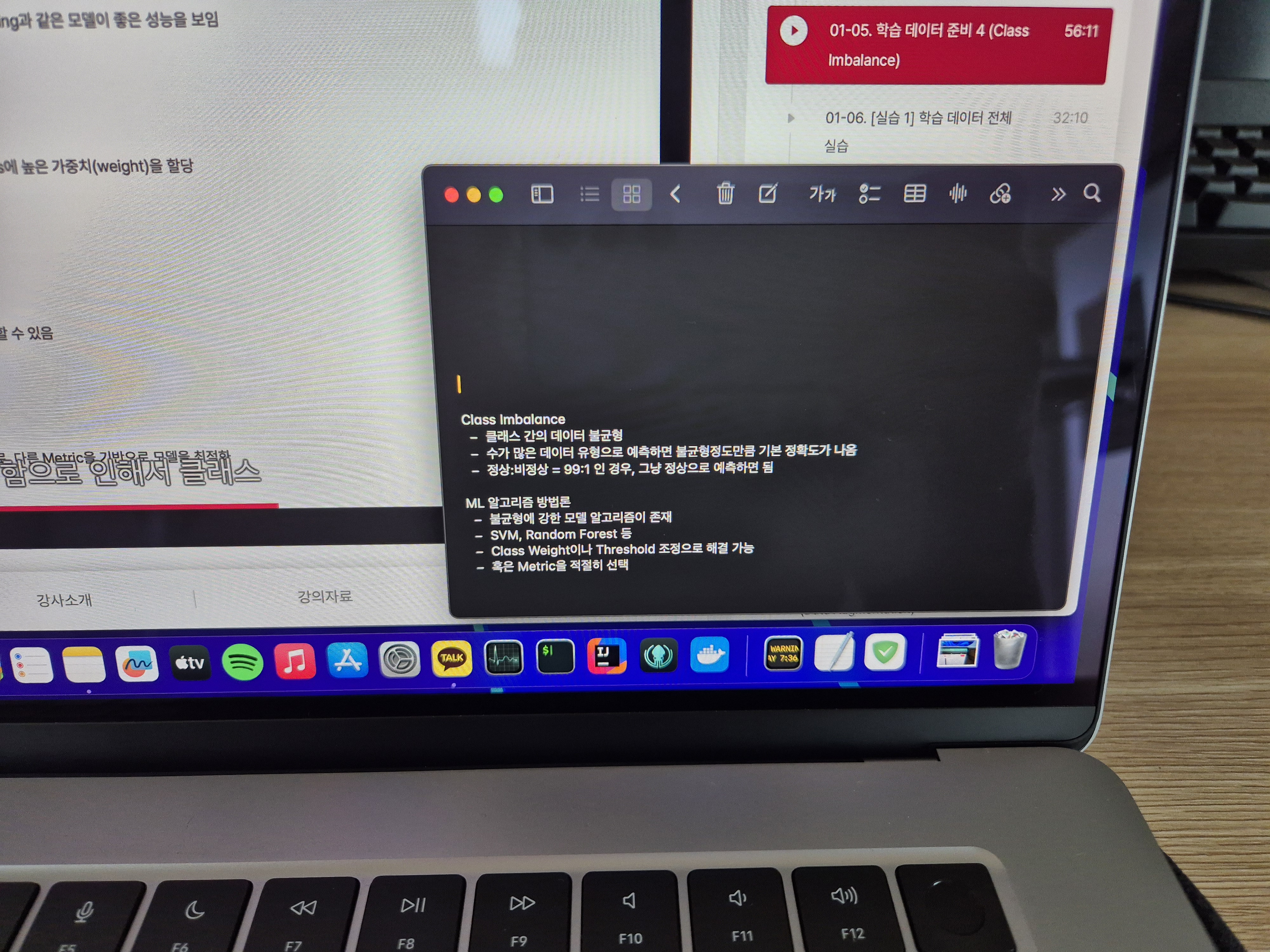

수강 인증

수강 후기

안녕하세요. 환급챌린지 4일차 포스팅입니다.

오늘은 Class Imbalance 문제와 이를 다양한 관점에서 해결하는 방법을 배웠습니다.

머신러닝 모델을 학습할 때 데이터 분포가 한쪽으로 치우쳐 있으면 모델이 특정 클래스를 더 많이 예측하는 문제가 발생할 수 있습니다. 예를 들어, 의료 데이터에서 특정 질병이 매우 드물게 나타나는 경우, 모델이 대부분 "정상"으로 예측해도 높은 정확도를 보이는 착시 효과가 생길 수 있습니다. 하지만 실제로 중요한 것은 드문 질병을 잘 탐지하는 것이므로, 이를 해결하기 위한 다양한 방법들이 필요합니다.

오늘 강의에서는 대표적인 해결 방법으로 데이터 레벨, 알고리즘 레벨, 평가 지표 관점에서 접근할 수 있음을 배웠습니다. 데이터 레벨에서는 오버샘플링과 언더샘플링 기법을 사용하여 클래스 간 균형을 맞출 수 있습니다. 오버샘플링은 소수 클래스의 데이터를 인위적으로 늘리는 방법이고, 언더샘플링은 다수 클래스의 데이터를 줄이는 방식입니다. 알고리즘 레벨에서는 가중치를 조정하거나, SMOTE(Synthetic Minority Over-sampling Technique) 같은 기법을 활용하여 모델이 적절히 학습할 수 있도록 조정할 수 있습니다. 또한, 단순히 정확도(Accuracy)만을 평가 지표로 사용할 경우 Class Imbalance 문제를 제대로 반영하지 못할 수 있기 때문에 정밀도(Precision), 재현율(Recall), F1-score 같은 지표를 함께 고려하는 것이 중요하다는 점도 강조되었습니다.

강의 내용 중 가장 흥미로웠던 부분은 SMOTE 기법이었습니다. 단순히 데이터를 복제하는 것이 아니라 기존 데이터를 기반으로 새로운 데이터를 생성하는 방식이기 때문에, 오버피팅을 방지하면서도 균형 있는 학습이 가능하다는 점이 인상적이었습니다. 실제 프로젝트에서 Class Imbalance 문제가 발생했을 때, 단순히 데이터 양을 조절하는 것뿐만 아니라 적절한 알고리즘과 평가 지표를 함께 고민하는 것이 중요하다는 점을 다시금 느낄 수 있었습니다.

이론을 듣다 보니 실제 데이터셋을 활용해서 직접 샘플링을 해보고 싶은 욕구가 생깁니다. 내일부터 실습이 진행된다면 SMOTE나 가중치 조정 같은 기법을 적용해 보고, 평가 지표에 따른 성능 차이를 분석해 보면 좋을 것 같습니다. 점점 실전적인 내용으로 들어가면서 배운 개념들을 코드로 직접 구현하고 싶어집니다.