철학과 학생의 개발자 도전기

패스트캠퍼스 환급챌린지 8일차 : 10개 프로젝트로 한 번에 끝내는 MLOps 파이프라인 구현 초격차 패키지 Online. 강의 후기 본문

패스트캠퍼스 환급챌린지 8일차 : 10개 프로젝트로 한 번에 끝내는 MLOps 파이프라인 구현 초격차 패키지 Online. 강의 후기

Younghun 2025. 3. 12. 23:26본 포스팅은 패스트캠퍼스 환급 챌린지 참여를 위해 작성하였습니다.

온라인 강의 7주년 기념 1+1 이벤트 특별 연장! (3/10~3/12) | 패스트캠퍼스

단 3일! 미션, 리뷰, 인증 NO! 강의 사면 무.조.건 1+1 쿠폰 증정🎉

fastcampus.co.kr

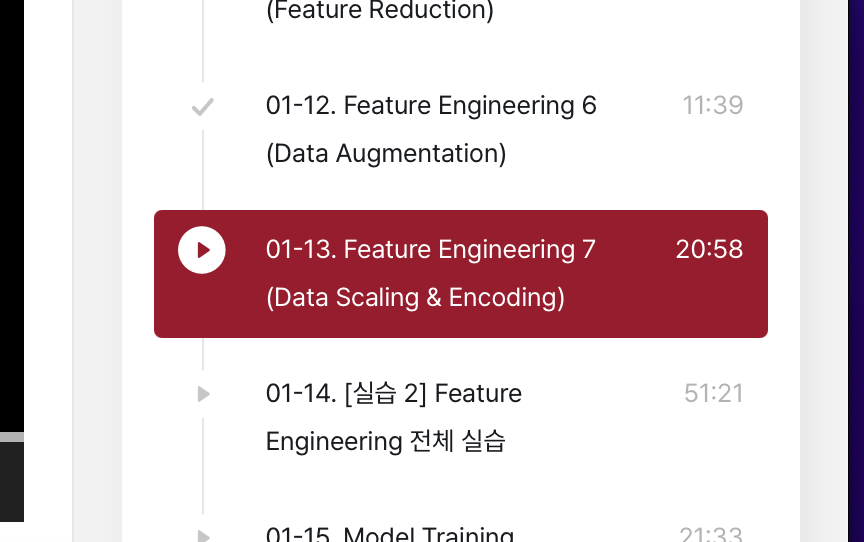

수강 인증

수강 후기

안녕하세요. 환급챌린지 8일차 포스팅입니다.

오늘은 Data Augmentation, Scaling, Encoding에 대해 배웠습니다.

오늘 강의를 듣고 다시 한번 데이터 전처리의 중요성을 실감했습니다. 모델 성능을 개선하는 데 있어 좋은 모델을 설계하는 것도 중요하지만, 그보다 먼저 데이터가 얼마나 잘 정리되고 가공되었느냐가 핵심이라는 생각이 들었습니다. 특히, 오늘 배운 Data Augmentation, Scaling, Encoding은 데이터 품질을 높이고 모델이 더 잘 학습할 수 있도록 돕는 필수적인 과정이라 더욱 흥미로웠습니다.

Data Augmentation: 데이터 부족 문제를 해결하는 방법

머신러닝 모델을 학습할 때 데이터가 많을수록 성능이 좋아지는 경우가 많지만, 현실적으로 충분한 데이터를 확보하는 것은 쉽지 않습니다. 이럴 때 활용할 수 있는 방법이 Data Augmentation(데이터 증강)입니다.

이미지 데이터의 경우 회전, 확대, 반전 등의 기법을 활용해 새로운 데이터를 생성할 수 있고, 자연어 처리에서는 문장을 약간 변형하는 방식으로 데이터를 늘릴 수 있습니다.

이 기법이 특히 유용하다고 느꼈던 이유는, 데이터를 더 수집하는 것이 어려운 경우에도 기존 데이터를 변형하여 모델의 일반화 성능을 높일 수 있기 때문입니다. 더 많은 데이터를 확보하는 것이 항상 가능한 것이 아니므로, 적절한 데이터 증강 기법을 활용하는 것이 좋은 해결책이 될 수 있다고 생각했습니다.

Scaling: 데이터의 스케일을 맞춰 모델이 더 잘 학습할 수 있도록 조정

데이터의 수치 범위가 너무 크거나 특성마다 차이가 클 경우, 모델이 올바르게 학습하기 어렵습니다. 예를 들어, 한 특성의 값이 10 범위인데, 다른 특성이 10000 범위라면 큰 값이 모델 학습에 더 큰 영향을 미칠 수 있습니다. 이를 방지하기 위해 Scaling(정규화) 기법을 활용합니다.

대표적인 방법으로는 다음과 같은 것들이 있습니다.

- Min-Max Scaling: 데이터를 0과 1 사이 값으로 변환

- Standard Scaling: 데이터를 평균 0, 표준편차 1을 갖도록 변환

강의를 들으면서 Scaling이 단순한 과정 같아 보이지만, 어떤 방법을 선택하느냐에 따라 모델 성능이 크게 달라질 수 있다는 점이 인상 깊었습니다. 실제 데이터에 적용해보면서 차이를 비교해 보고 싶어졌습니다.

Encoding: 범주형 데이터를 숫자로 변환하는 과정

데이터에는 숫자뿐만 아니라 "서울", "부산", "대구" 같은 문자 데이터(범주형 데이터)도 포함될 수 있습니다. 하지만 머신러닝 모델은 텍스트를 그대로 이해하지 못하기 때문에, 이를 숫자로 변환하는 과정이 필요합니다.

대표적인 방법으로는 다음과 같은 것들이 있습니다.

- One-Hot Encoding: 각 범주를 0과 1로 변환 (예: "서울" → [1,0,0], "부산" → [0,1,0])

- Label Encoding: 각 범주를 숫자로 변환 (예: "서울" → 0, "부산" → 1, "대구" → 2)

Encoding 기법을 배우면서 단순히 변환하는 것이 아니라, 데이터 특성에 따라 적절한 방법을 선택하는 것이 중요하다는 점을 배웠습니다. 예를 들어, Label Encoding은 숫자의 크기가 의미를 가질 수 있기 때문에, 순서가 없는 데이터에는 One-Hot Encoding이 더 적절할 수 있습니다.

오늘 배운 내용에서 얻은 인사이트

오늘 강의를 들으며, 데이터 전처리가 모델 성능을 결정짓는 중요한 과정이라는 것을 다시 한번 실감했습니다. 단순히 데이터를 변환하는 것이 아니라, 모델이 더 잘 이해할 수 있도록 데이터를 최적화하는 과정이라는 점에서 매우 중요한 작업이라는 생각이 들었습니다.

특히, Data Augmentation은 단순히 데이터를 늘리는 것이 아니라, 모델의 일반화 성능을 높이는 강력한 도구라는 점이 흥미로웠습니다. Scaling과 Encoding 역시 단순한 변환이 아니라, 데이터가 모델에게 더 잘 전달될 수 있도록 정리하는 과정이라는 걸 배울 수 있었습니다.

이제 전처리 과정이 점점 익숙해지고 있는데, 앞으로 실습을 통해 직접 적용해 보면서 어떤 방식이 가장 효과적인지 체감해 보고 싶습니다.